大型语言模型面临的挑战与应用全面解析

还记得第一次体验 ChatGPT 时的震撼吗?那种”这真的是机器写的?“的惊讶感,至今让很多开发者印象深刻。

大型语言模型(LLM)正在改变我们对 AI 能力的认知。从写代码到分析数据,从客服聊天到创意写作,这些模型几乎无处不在。但它们真的有那么神奇吗?又面临哪些现实挑战?

作为技术人员,我们需要冷静地看待这项技术——既不盲目崇拜,也不无视其潜力。

1. 简单说,LLM 是什么?

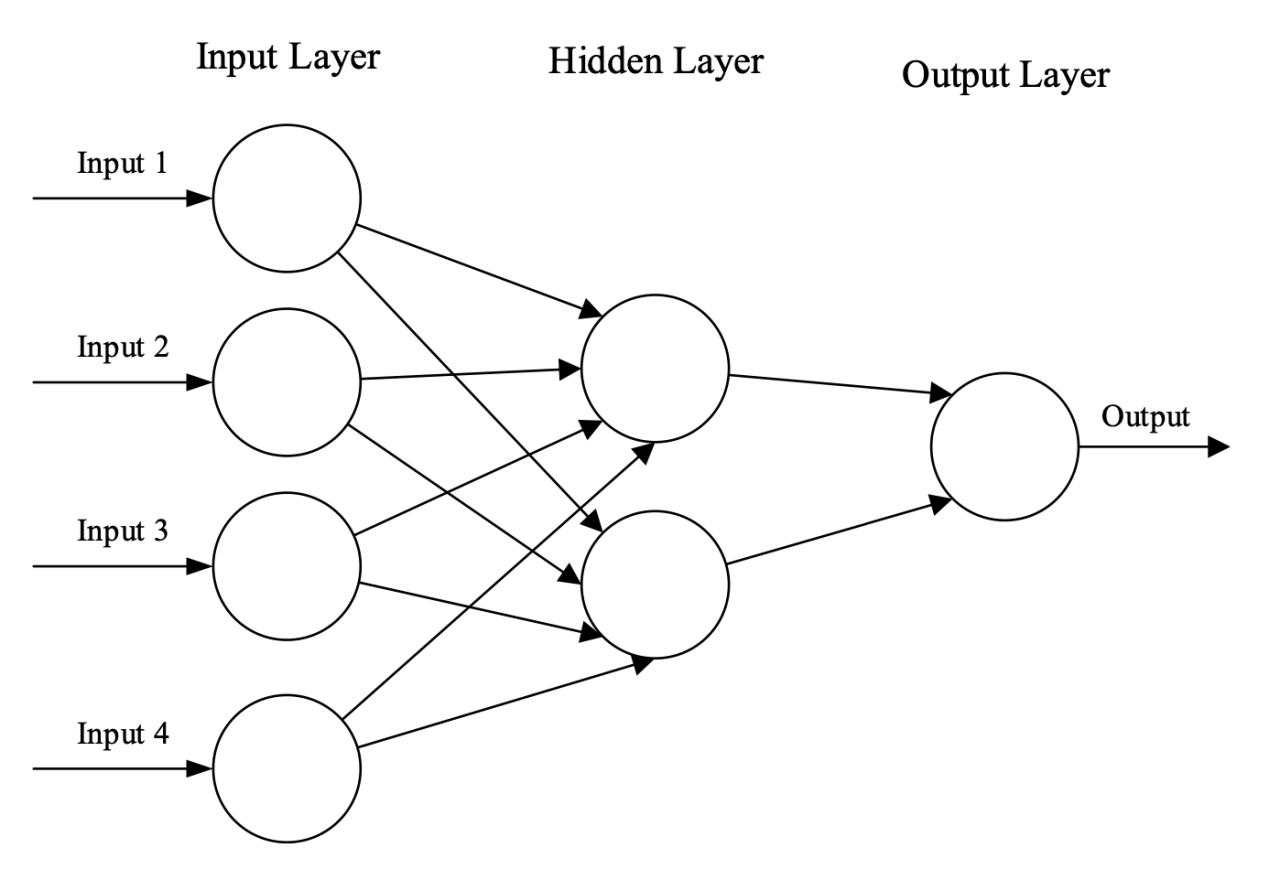

想象一下,有一个非常聪明的助手,读过互联网上几乎所有的文章、书籍和对话记录。现在你问它任何问题,它都能给出相当不错的回答。这就是 LLM 的基本原理。

从技术角度看,LLM 本质上是个”模式识别大师”。它通过分析海量文本数据,学会了语言的规律——什么词通常跟什么词搭配,什么样的句子结构更常见,甚至什么样的逻辑推理更合理。

比如,当你输入”今天天气不错,适合”时,它知道后面很可能是”出门”、“运动”或”晾衣服”,而不是”睡觉”。

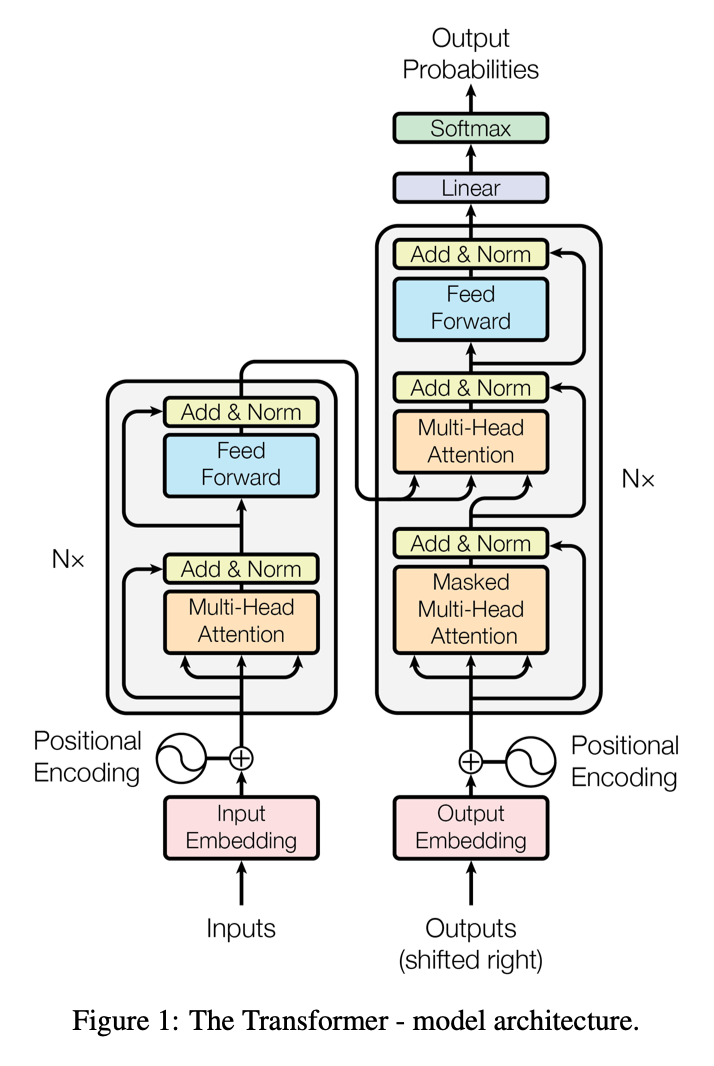

关键技术突破:Transformer 架构

2017 年之前,AI 处理语言就像一个人逐字逐句地阅读,效率很低。Transformer 的出现改变了游戏规则——它能同时”看到”整个句子,理解词汇之间的关系。

就像你读一本小说时,能够记住前面的情节,理解后面的发展一样。GPT、BERT、LLaMA 这些我们熟悉的模型,都是基于这个架构构建的。

2. LLM 的真实挑战:理想很丰满,现实很骨感

作为开发者,我们都知道没有完美的技术。LLM 也不例外,它面临的挑战比你想象的更复杂。

2.1 数据质量:垃圾进,垃圾出

训练 LLM 需要海量数据——通常是几十 TB 的文本。问题是,这些数据从哪来?互联网。而互联网上什么都有:优质文章、垃圾内容、偏见观点、错误信息。

就像你把一堆好书和烂书混在一起让学生读,学生必然会学到一些错误的东西。数据清洗是个大问题,人工检查几十 TB 的数据?不现实。

2.2 成本高得离谱

训练一个像 GPT-3 这样的模型,估计要花费几百万美元。即使是微调,也需要大量 GPU 资源。

对大多数公司来说,这个门槛实在太高了。这也是为什么现在大家都在用 API,而不是自己训练模型。

2.3 “幻觉”问题:一本正经地胡说八道

这可能是 LLM 最让人头疼的问题。模型会编造一些听起来很有道理但完全错误的信息。

比如,你问它某个不存在的 API 文档,它可能会给你一套完整的、看起来很专业的说明。如果你不仔细验证,很容易被误导。

2.4 提示词敏感:换个说法结果大不同

你有没有遇到过这种情况:同样的问题,稍微换个表达方式,LLM 给出的答案完全不同?

这种”脆弱性”让在生产环境中使用 LLM 变得很棘手。你需要大量测试不同的提示词,确保结果的稳定性。

2.5 知识更新滞后

LLM 的知识有个”截止日期”。比如 GPT-3.5 的知识截止到 2021 年,它不知道之后发生的事情。

这在快速变化的技术领域尤其明显。你问它最新的框架版本或 API 变化,它可能给你过时的信息。

3. LLM 能做什么?看看这些实际应用

3.1 代码助手:程序员的新搭档

GitHub Copilot、Cursor 这些工具现在很多开发者都在用。你写注释,它帮你生成代码;你写一半,它帮你补全。虽然生成的代码质量参差不齐,但确实能提高效率。

我身边不少同事已经离不开 AI 编程助手了。特别是写一些标准的 CRUD 操作、数据处理脚本,基本上让 AI 先写个初版,然后自己再调整。

3.2 智能客服:24 小时在线

现在很多公司的客服都接入了 LLM。用户问问题,AI 先尝试回答,解决不了再转人工。

比较成功的案例是一些电商平台的售前咨询,AI 能处理 80% 的常见问题:产品规格、价格、配送等。剩下的复杂问题再由人工处理。

3.3 内容创作:从初稿到精修

不少内容创作者在用 LLM 辅助写作。不是让 AI 完全代替,而是用它来:

- 生成文章大纲

- 扩展某个观点

- 润色文字表达

- 翻译和本地化

营销团队用它生成广告文案初稿,编辑用它做内容校对,效果还不错。

3.4 数据分析助手

对于非专业的数据分析师来说,LLM 是个好帮手。你可以用自然语言描述需求:“分析一下上个月的销售数据,找出哪些产品卖得最好”,它能帮你生成相应的 SQL 或 Python 代码。

当然,复杂的业务分析还是需要专业人士,但日常的数据查询和简单统计,LLM 已经能胜任。

3.5 其他有趣的应用

- 医疗辅助:帮医生整理病历、检索医学文献

- 法律研究:协助律师查找相关案例和法条

- 教育培训:个性化答疑、生成练习题

- 创意设计:生成文案、协助界面布局

但要记住,这些都是”辅助”作用,最终的决策还是要人来做。

4. 企业如何接入 LLM?实用建议

4.1 选择服务商:不要只看价格

市面上的 LLM API 服务很多:OpenAI、Claude、国内的 DeepSeek、文心一言等。选择合适的服务商需要综合考虑多个因素。首先建议每家都注册试用一下,用你的实际业务场景测试,看看哪个模型的回答质量最符合预期。很多人容易被低价吸引,但 API 的响应时间和可用性往往比便宜几毛钱更重要,系统宕机一小时的损失可能远超你节省的成本。

如果你的应用主要处理中文内容,国内的服务可能在语言理解上有优势,而且数据不出境在合规方面也更简单。当然,不同行业对数据安全的要求不同,金融、医疗等敏感行业需要特别关注服务商是否符合相关的监管要求。

4.2 提示词工程:90% 的效果在这里

很多人低估了提示词的重要性。同样的模型,好的提示词和差的提示词,效果可能天差地别。想要获得好的结果,首先要明确告诉 AI 它的身份角色,比如”你是一个专业的客服代表”,这样它就知道该用什么语气和专业水准来回答。同时需要设定清晰的边界,明确什么能做、什么不能做,避免 AI 胡乱发挥。

在具体的指导上,给几个输入输出的示例往往比长篇大论的说明更管用。AI 很擅长从例子中学习模式。另外,如果你需要特定格式的输出,比如 JSON 或 Markdown,一定要在提示词中明确说明。

举个对比的例子,糟糕的提示可能只是”帮我写个回复”,而好的提示应该是:“你是客服代表,用礼貌专业的语气回复客户。如果是技术问题,转接给技术支持。如果是投诉,表示理解并提供解决方案。回复长度控制在 100 字以内。“这样的指导更具体,AI 的表现自然更好。

4.3 成本控制:别被 API 账单吓到

LLM API 按 token 收费,长文本生成费用不菲。控制成本的第一步是设置合理的输出长度限制,通过 max_tokens 参数避免模型生成过长的回复。同时要优化提示词的表达,简洁的提示词意味着更少的输入 token,累积下来能省不少钱。

对于常见问题,建议建立缓存机制,相同的问题不要重复调用 API。另外,根据任务的复杂程度选择合适的模型也很重要,简单的文本分类任务没必要用最强的模型,小模型往往既便宜又够用。有些企业还会设置每日调用额度上限,避免意外的大额账单。

4.4 安全考虑:不要裸奔

在安全方面,首要原则是敏感信息绝对不要直接发给 LLM。客户的身份证号、银行账户、内部商业机密等数据在传给 API 之前必须进行脱敏处理。同时需要建立输出过滤机制,设置关键词黑名单,防止 AI 生成不当内容或泄露敏感信息。

访问控制也很重要,要限制哪些员工能使用 LLM 功能,避免无关人员随意调用。最后,记录所有的 API 调用日志是必须的,包括谁在什么时间调用了什么接口,输入和输出的内容是什么。这样出现问题时能够快速追踪定位,也有利于后续的安全审计。

4.5 监控和优化

部署 LLM 应用后,持续监控是保证服务质量的关键。要定期抽查 AI 的回复质量,看看是否还符合业务要求,特别是在模型更新或业务场景变化后。用户反馈是另一个重要的指标,可以通过”这个回答有用吗”这样的简单评价来收集数据。

从技术角度,需要监控 API 调用的响应时间、成功率等指标,确保系统稳定运行。成本分析也不能忽视,要跟踪每天的 API 使用费用,识别哪些场景消耗最多,然后针对性地优化调用策略。有些公司还会根据用户满意度和成本效益来调整 LLM 的使用范围,把 AI 用在最有价值的地方。

5. 未来会怎样?

5.1 技术本身会越来越好

LLM 的发展还远未结束。在推理能力方面,我们可能会看到模型能够解决更复杂的数学问题,编写质量更高的代码,甚至进行多步骤的逻辑推理。多模态整合是另一个重要方向,未来的模型可能像人类一样同时处理文字、图片、音频信息,真正理解多媒体内容。

成本方面的改善也值得期待。随着模型压缩技术和推理优化算法的发展,运行 LLM 的成本会大幅降低,让普通企业也能负担得起高质量的 AI 服务。最重要的是,“幻觉”问题会逐步改善,模型的准确性将大幅提升,在医疗、法律等专业领域变得更加可靠。

5.2 应用会更加普及

现在 LLM 还主要是科技公司在使用,但未来可能会像搜索引擎一样普及到各行各业。我们会看到越来越多专门针对特定行业训练的模型,比如医疗领域的模型能理解病历和医学术语,法律领域的模型熟悉各种法条和案例,金融领域的模型懂得风险评估和投资分析。

技术门槛也会大幅降低。未来的 LLM 集成可能像现在接入支付 API 一样简单,不需要深厚的 AI 知识就能为自己的应用添加智能功能。更令人期待的是边缘计算的发展,小型的 LLM 可能直接部署在手机、智能家居甚至工业设备上,实现真正的本地化智能处理。

5.3 现实的挑战

但我们也要认清现实,LLM 不会完全替代人类工作。AI 更适合做辅助性的工作,比如信息检索、初稿撰写、数据分析等,而涉及复杂判断、创意决策、人际沟通的工作还是需要人来完成。过度依赖 AI 可能导致人类能力的退化,这是需要警惕的。

监管环境也会越来越严格。各国政府已经开始关注 AI 的伦理和安全问题,未来在数据使用、算法透明度、责任归属等方面会有更多的法规限制,企业的合规成本必然增加。同时,虽然技术门槛会降低,但要真正用好 LLM,还是需要对业务场景的深刻理解和专业的提示词设计能力。

6. 给开发者的建议

现在就开始学习,不用等到技术完全成熟。现在就开始接触 LLM,了解它的能力和局限性。这样当机会来临时,你已经准备好了。

专注实际价值,不要被炒作迷惑。LLM 很强大,但不是万能的。找到它真正能解决的问题,为用户创造实际价值。

保持谨慎乐观,LLM 确实会改变很多工作方式,但变化是渐进的,不是颠覆性的。做好准备,但不要过度投资。

最重要的是:技术在变,但解决真实问题的初心不变。LLM 只是工具,关键还是要用它做出有价值的产品。